Kim Seon Deok

LSTM 본문

RNN의 한계

long-term dependency

중요한 정보가 recurrent step이 계속됨에 따라 희석되는 문제

LSTM(Long short - term memory)

RNN의 한계를 보완중요한 정보만 선택하여 다음 state에 전달함Cell에 정보를 저장정보들은 gate에 의해서 선택됨 >> 중요한 정보들을 오랜기간 동안 가지고 멀리 갈 수 있게 한 구조

Cell state = 사람의 장기기억

모든 LSTM 연산을 관통하는 vector학습 데이터를 관통하는 중요한 정보들을 가지고 있음Gate구조를 통해 정교하게 정보가 추가되고 삭제됨목적 : 정보 보관!

* RNN의 state vs LSTM의 state

RNN의 state : 정보 저장, 정보 전달을 모두 함

LSTM의 state - 정보 저장 : LSTM cell

- 정보 전달 : LSTM ht

Gate machanism

정보를 걸러주는 역할 = 체목적에 필요한 중요한 정보라면 통과, 필요하지 않은 정보라면 통과 xLSTM에는 3가지의 Gate구조가 존재Cell state의 정보를 보호 sigmoid함수를 이용해 문지기와 같은 역할을 함Cell state vector의 각 값들에 0~1의 값을 곱해서 빠져나오는 양을 조절

1.Forget gate layer

-Cell state에서 어떤 정보를 지워버릴 지 결정

-ht-1과 xt를 활용해 (linear연산) t 시점의 입력에 대해 어떤 정보를 지울지 결정

-결과 vector는 Cell state의 크기와 동일 (0 : 완전히 제거, 1 : 완전히 보존)

2.Candidate layer(gate구조가 아님)

-입력으로 들어온 정보를 1번 정제

3.Input gate layer

-ht-1과 xt를 활용해 Candidate vector에서 뭘 넣어줄지 결정-0~1 사이의 값-Candidate vector에 곱해져서 cell state에 더해질 준비

Old Cell state를 새로운 Cell state로 업데이트

Forget gate layer의 결과물로 이전 Cell state에서 제거될 정보가 제거되고

xt와 ht-1의 값을 이용해 Cell state에 들어갈 후보 값들로 Candidate로 뽑아낸 뒤, 이 값들은 Input gate layer에 의해 걸러져서 Cell state에 추가되어 새로운 Cell state가 완성!

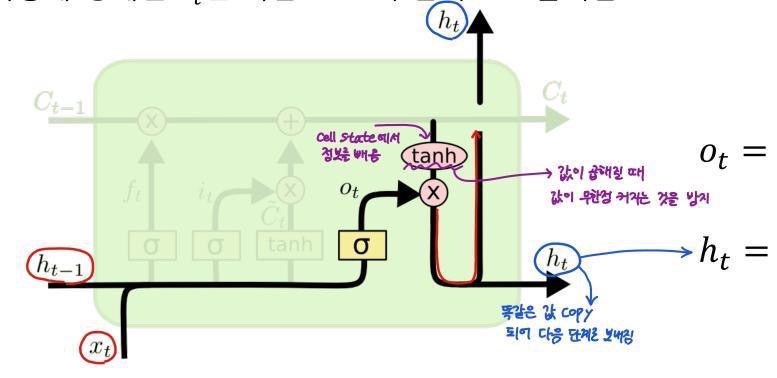

결과를 위해 사용할 vector 내보내주기

4.output gate layer

-Cell state에서 잠시 빼 올 필요한 정보를 결정

-t시점의 정보를 내보내 주어야 하므로 xt와 ht-1을 이용해 정보 추출용 gate를 생성

-이렇게 정해진 ht는 다음 state의 입력으로 들어감

LSTM 정리

'AI > Deep Learning' 카테고리의 다른 글

| 1. Back propagation (0) | 2022.01.21 |

|---|---|

| 딥러닝 학습방법론 (0) | 2021.11.23 |

| 딥러닝 기초이론 학습의 과정-2 : Loss and Gradient (0) | 2021.11.23 |

| 1. 딥러닝 학습 기초 (0) | 2021.11.22 |

| RNN 기초 (0) | 2021.11.19 |